OpenAI GPT-OSS 20B, 로컬에서 Ollama로 간편하게 실행하는 방법

로컬에서 GPT-OSS 모델 활용하기: Ollama와 OpenAI의 만남

최근 OpenAI가 GPT-2 이후 처음으로 오픈소스 대형 언어 모델(LLM)인 GPT-OSS를 공개하며 AI 개발자 및 연구자 커뮤니티에 큰 파장을 일으켰습니다. 이제 누구나 자신의 로컬 환경에서 강력한 AI 모델을 직접 실행하고 제어할 수 있는 시대가 열린 것입니다.

본 글에서는 Ollama라는 도구를 활용하여 로컬 환경에서 GPT-OSS 모델을 손쉽게 사용하는 방법에 대해 알아보도록 하겠습니다.

GPT-OSS: OpenAI의 새로운 오픈소스 모델

GPT-OSS 모델은 OpenAI가 아파치 2.0(Apache 2.0) 라이선스로 공개한 오픈소스 언어 모델입니다. 소스 코드 수정, 2차 창작, 상업적 이용까지 가능해 개발자들에게 높은 자유도를 제공합니다.

현재 공개된 주요 버전은 다음과 같습니다.

- gpt-oss-120b

- 매개변수: 1,168억 개

- 성능: OpenAI의 고성능 모델인

o4-mini에 근접한 수준 - 특징: 복잡한 추론 및 전문적인 작업에 강점

- 권장 환경: H100 80GB급 고성능 GPU

- gpt-oss-20b

- 매개변수: 209억 개

- 성능:

o3-mini에 준하는 수준 - 특징: 16GB 이상 VRAM 환경에서도 실행 가능

- 권장 환경: 일반 개발자 및 로컬 테스트용

Ollama: 로컬 LLM 구동을 위한 도구

Ollama는 로컬 환경에서 대형 언어 모델을 간편하게 다운로드하고 실행할 수 있도록 지원하는 오픈소스 플랫폼입니다. 복잡한 설정 과정 없이 몇 가지 명령어만으로 모델을 실행할 수 있으며, 최근 업데이트로 웹 기반 GUI가 추가되어 활용 편의성이 한층 높아졌습니다.

아래 링크를 통해 사용 중인 운영체제에 맞는 Ollama 버전을 다운로드할 수 있습니다.

- Ollama 다운로드 링크 : https://ollama.com/download

Ollama의 기능과 활용 방법에 대해 더 자세히 알고 싶으시다면, 아래 블로그 글을 참고하시기 바랍니다.

- AIMIZING 블로그 : Ollama 업데이트 소개

로컬 환경에서 GPT-OSS 모델 실행하기 (Ollama 활용)

본격적으로 로컬 환경에서 Ollama를 사용하여 GPT-OSS 모델을 사용하는 방법에 대해 알아보겠습니다.

1. 실행 환경

- 운영체제 : Windows 11

- Ollama : 0.11.4

- GPU : NVIDIA GeForce RTX 4060 Ti (VRAM 16 GB)

2. Ollama 설치

- Ollama 공식 다운로드에서 운영체제(macOS, Windows, Linux)에 맞는 버전 다운로드 및 설치

3. GPT-OSS 모델 다운로드 및 실행

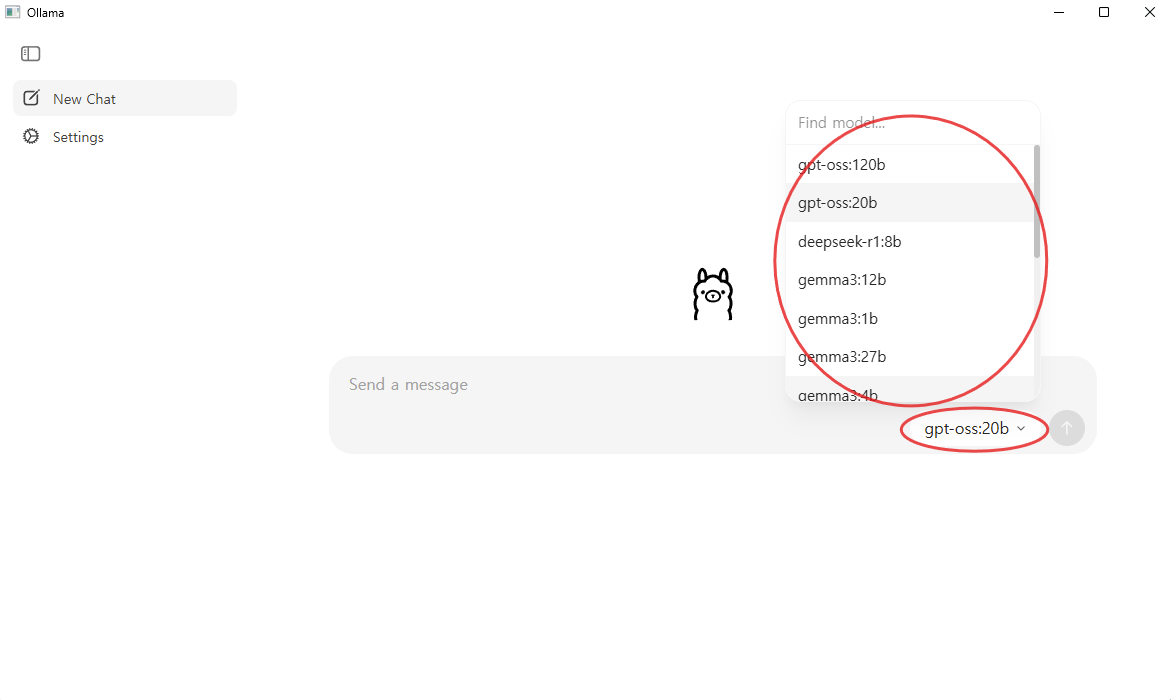

Ollama 최신 버전에서는 GUI 애플리케이션을 통해 간편하게 GPT-OSS를 실행할 수 있습니다.

- Ollama를 실행해줍니다. (Windows 환경이라면 아래 작업 표시줄에서 Ollama 아이콘으로 실행)

- 프롬프트 입력창 우측에서 작동할 모델을 선택할 수 있으며, 여기서 "GPT-OSS:20b" 모델을 선택하면 됩니다. (첫 번째 이미지 참조)

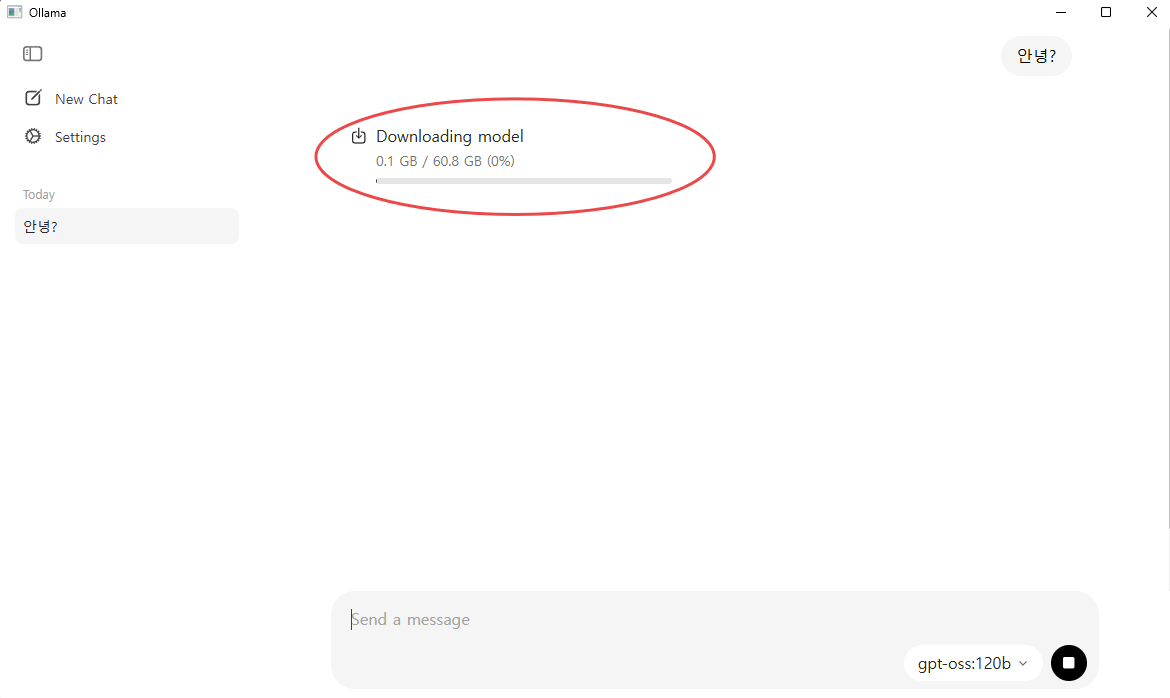

- 이후 질문을 입력하면 실행이 시작됩니다. 만약 해당 모델이 로컬에 다운로드되어 있지 않다면 자동으로 다운로드가 진행됩니다. (두 번째 이미지 참조)

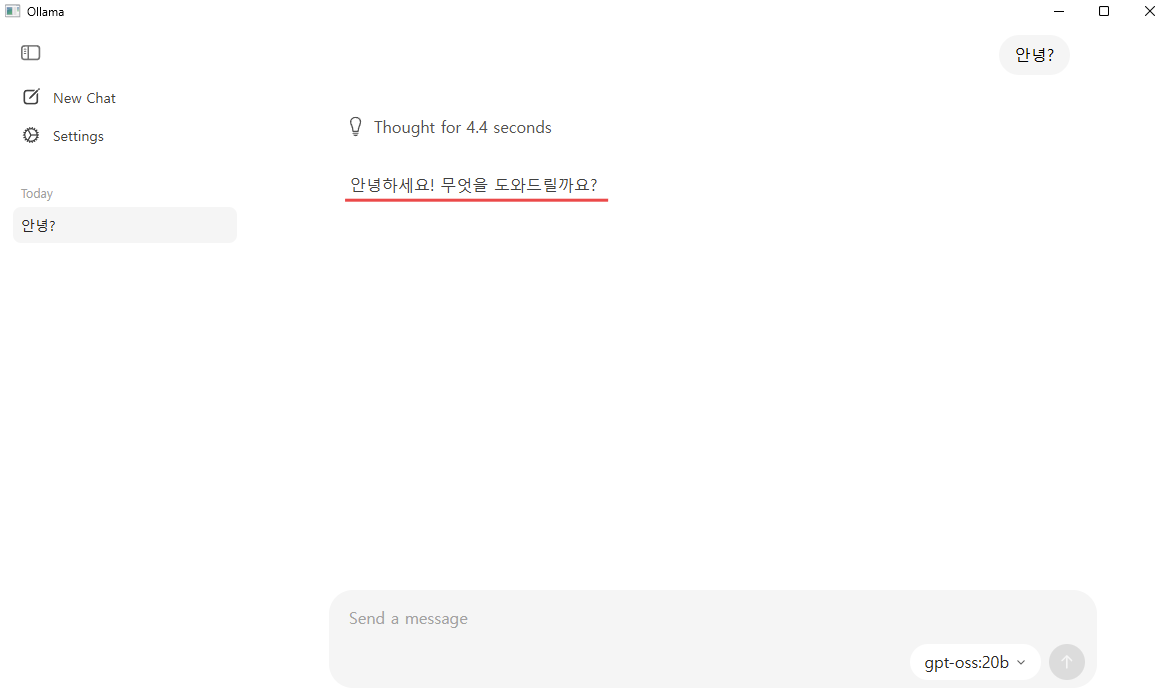

- 다운로드가 완료되면 입력한 질문에 대한 답변이 바로 제공됩니다. (세 번째 이미지 참조)

4. GPT-OSS 모델 실행결과

실행 테스트 결과, GPU VRAM 사용량은 약 14.7GB로 확인되었습니다.

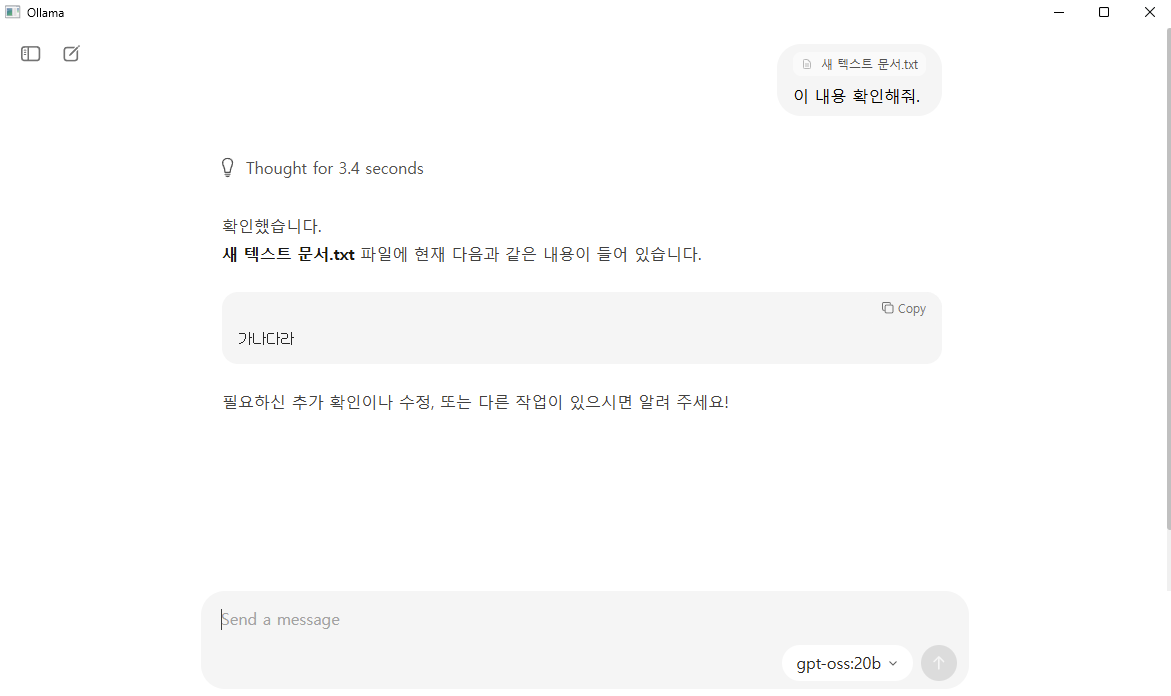

이 모델은 기본적으로 텍스트 입력을 지원하며, 이미지나 엑셀 파일과 같은 비정형 데이터 입력은 현재 지원하지 않습니다.

다만 .txt 형식의 텍스트 파일은 직접 입력할 수 있어, 문서 기반 질의응답이나 분석 작업에 활용할 수 있습니다.

또한 추론 모델로서 다양한 형태의 텍스트 기반 분석과 문제 해결이 가능하며, 복잡한 질문에도 일관된 논리적 응답을 제공했습니다.

아래는 실제 GPT-OSS:20B 모델을 Ollama에서 실행한 결과 화면입니다.

주의 사항

이 방식으로 실행되는 GPT-OSS:20B 모델은 전적으로 로컬 환경에서 구동됩니다. 따라서 외부 서버로 데이터가 전송될 우려가 없으며, 인터넷 연결 없이도 완전한 오프라인 상태에서 사용할 수 있습니다. 이는 보안과 개인정보 보호 측면에서 큰 장점이 있습니다.

다만, 모델의 처리 속도와 응답 품질은 전적으로 사용자의 하드웨어 성능에 좌우됩니다. 특히 GPU 메모리 용량, CPU 성능, 저장 장치 속도 등에 따라 체감 성능이 크게 달라질 수 있으므로, 원활한 사용을 위해서는 충분한 사양의 환경을 갖추는 것이 좋습니다.

마무리

이번 글에서는 로컬 환경에서 Ollama를 사용해 GPT-OSS:20B 모델을 실행하는 방법을 살펴보았습니다. Ollama의 간단한 설치와 GUI 환경을 통해, 복잡한 설정 없이도 고성능 언어 모델을 로컬에서 안전하게 활용할 수 있다는 점이 큰 장점입니다. 특히 인터넷 연결 없이 동작하고, 데이터가 외부로 전송되지 않는 구조이므로 보안과 개인정보 보호에 민감한 사용자에게 적합합니다.

앞으로 GPT-OSS를 기반으로 한 다양한 응용 사례가 등장할 것으로 예상되며, 사용자는 자신의 하드웨어 환경과 목적에 맞게 모델을 커스터마이징하여 더욱 폭넓게 활용할 수 있을 것입니다.

이제 로컬 환경에서도 손쉽게 최첨단 AI 모델을 체험해 보시기 바랍니다.

[참고 링크]

👉 Ollama 다운로드 : https://ollama.com/download

👉 AIMIZING 블로그 포스팅 : Ollama 업데이트 소개