Ollama 업데이트, 데스크톱 앱 출시

🐑 Ollama 새 데스크톱 앱 출시: 로컬 LLM 사용성이 한층 편해졌습니다

2025년 7월 30일, Ollama에서 공식적으로 GUI 앱을 공개하였습니다. 이 앱은 macOS·Windows 운영체제에서 사용이 가능하며, 터미널 없이도 모델을 다운로드·채팅·파일 분석할 수 있도록 지원합니다. 드래그-앤-드롭, 멀티모달 입력, 컨텍스트 길이 조절 등 사용자 친화 기능이 대폭 추가되었습니다.

✨ 주요 업데이트

- GUI 채팅 창 제공 → 터미널 입력 없이도 대화형으로 모델을 이용합니다.

- 파일 드래그-앤-드롭 → PDF·코드·문서 파일을 그대로 넣어 요약·분석이 가능합니다.

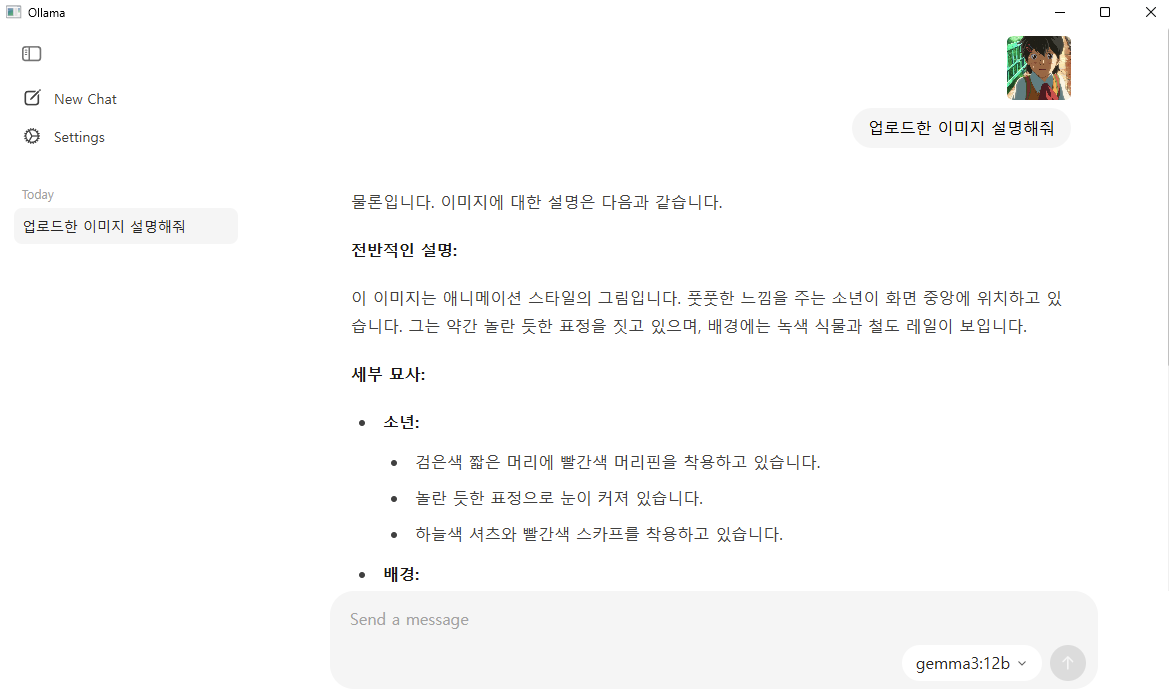

- 멀티모달 지원 → 이미지까지 전달하여 Gemma 3 등 시각 모델과 대화할 수 있습니다.

- 컨텍스트 길이 슬라이더 → 대용량 문서 처리 시 메모리 사용량을 조율합니다.

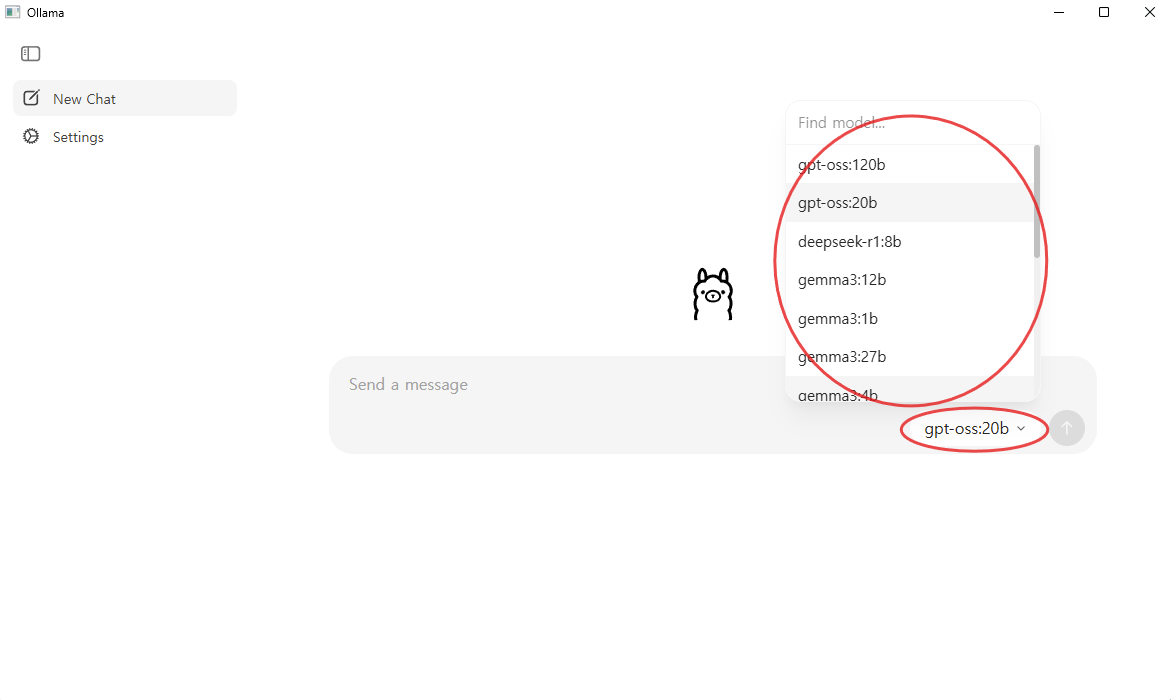

- 간편 모델 다운로드 → 드롭다운에서 모델을 선택하면 자동으로 내려받습니다.

- 트레이·시작 메뉴 실행 → 설치 후 백그라운드에서 상시 대기하며 빠르게 호출할 수 있습니다.

🖥️ CLI vs 새 GUI 앱 기능 비교

기존의 Ollama는 명령 프롬프트(터미널)에서 명령어를 입력해 사용하는 CLI 기반 도구였습니다. 이번 업데이트를 통해 Ollama는 대화형 GUI 애플리케이션으로도 제공되어, ChatGPT와 같은 웹 인터페이스 환경과 유사하여 직관적으로 사용할 수 있도록 개선되었습니다.

| 구분 | 기존 CLI | 새 GUI 앱 |

|---|---|---|

| 채팅 UI | 터미널 입력 | 대화형 창 |

| 모델 다운로드 | ollama pull 명령 | 드롭다운 클릭 |

| 파일 입력 | 경로 지정 필요 | 드래그-앤-드롭 |

| 이미지·코드 이해 | 파라미터 수동 설정 | 기본 지원 |

| 모델 푸시·빌드 | 지원 | 미지원 (CLI 필요) |

| 설치 형태 | 경량 CLI | GUI+CLI 통합 |

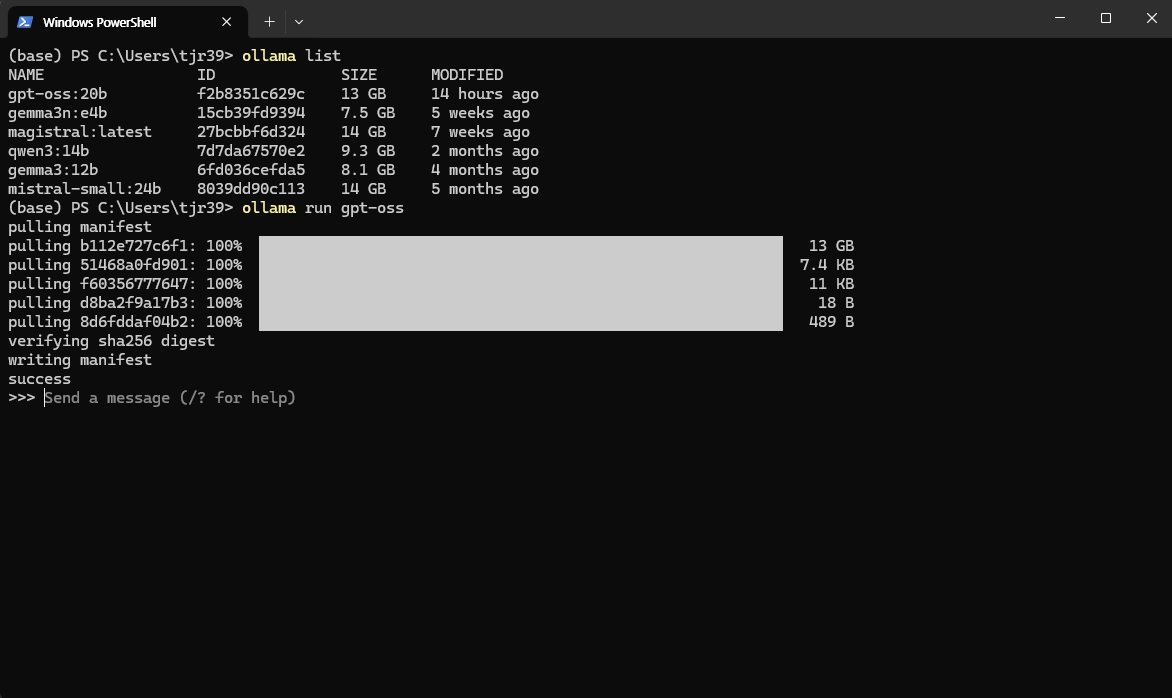

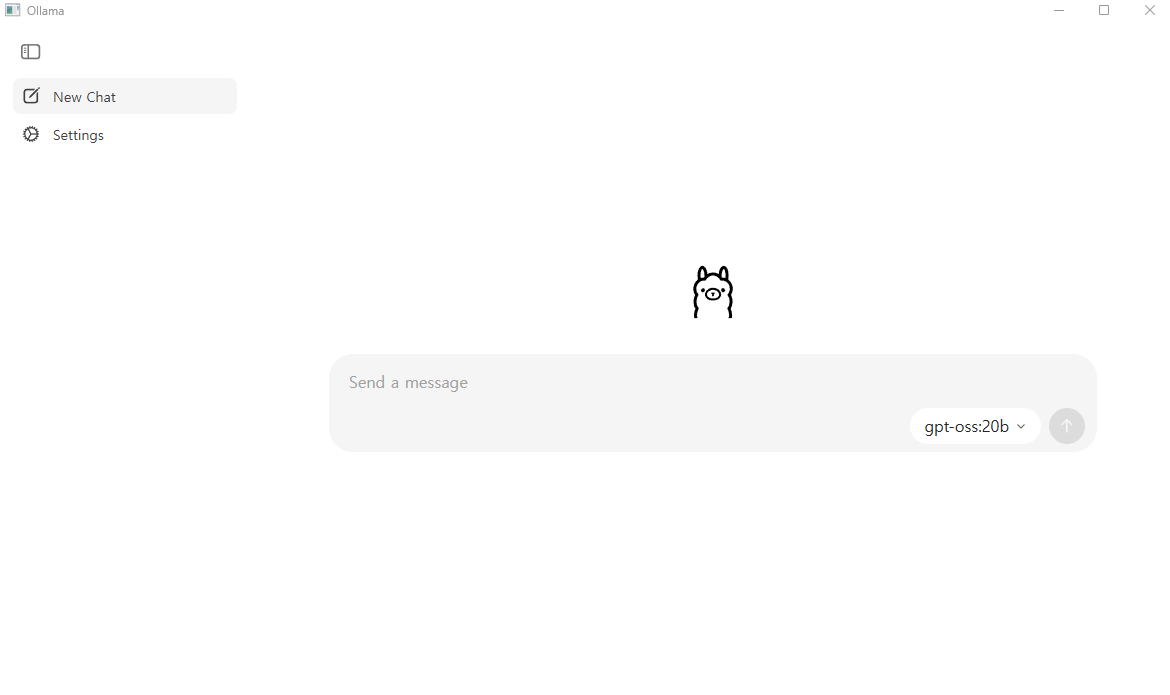

아래 이미지는 Ollama의 구버전(좌측)과 신버전(우측) 실행 화면을 비교한 예시입니다.

- 좌측은 Windows PowerShell에서 CLI 방식으로 Ollama를 실행한 모습이며,

- 우측은 새롭게 출시된 GUI 애플리케이션을 통해 실행한 화면입니다.

🔍 업데이트 후 기대 효과

이번 Ollama GUI 업데이트는 단순한 기능 추가를 넘어, 사용자 경험 전반에 긍정적인 변화를 가져왔습니다.

- 더 쉬운 사용 환경: 명령어에 익숙하지 않은 사용자도 손쉽게 LLM을 실행할 수 있습니다.

- 업무 흐름 최적화: 다양한 파일 입력 및 멀티모달 지원으로 생산성이 높아집니다.

- 안전한 사용 방식: 인터넷 연결 없이도 작동하므로, 민감한 정보를 로컬에서 안전하게 처리할 수 있습니다.

⚙️ 빠른 시작 가이드

- Ollama 공식 사이트에서 macOS 또는 Windows 설치 파일을 내려받습니다.

- 설치 후 Ollama를 실행하고 대화창을 엽니다.

- 드롭다운에서 원하는 모델을 선택하면 자동으로 다운로드됩니다.

- 분석할 PDF·이미지·코드 파일을 채팅창으로 끌어다 놓습니다.

- 필요 시 설정 메뉴에서 컨텍스트 길이를 확장하여 대용량 문서를 처리합니다.

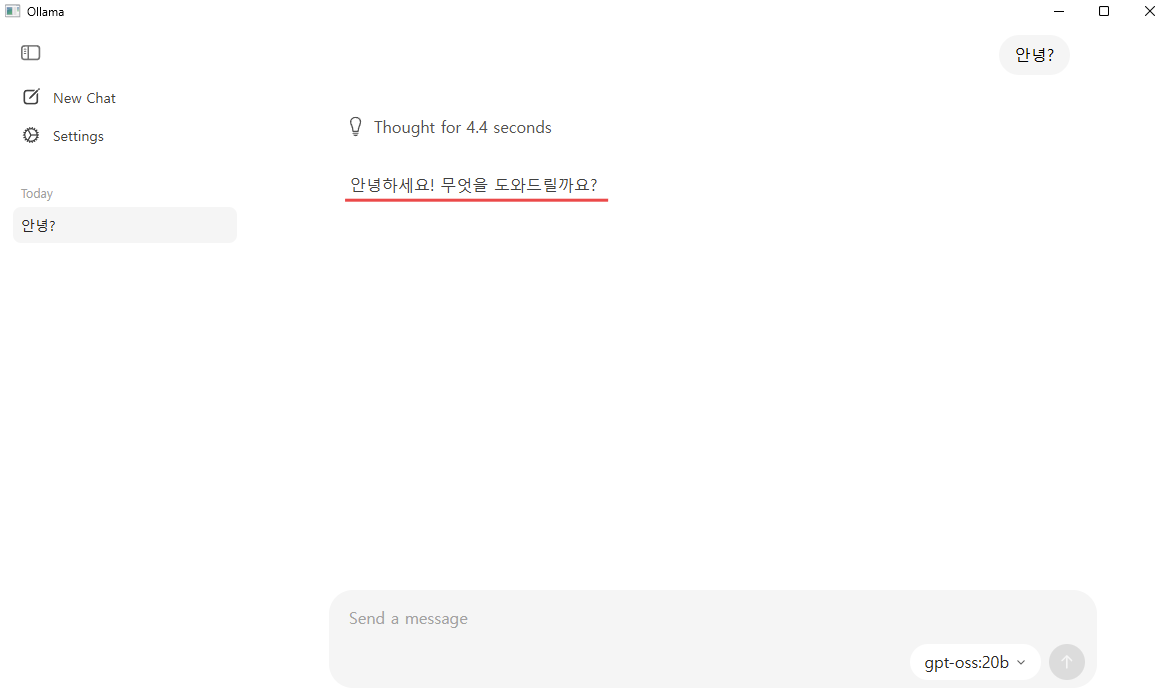

Ollama GUI를 실행하면 다음과 같은 화면이 나타납니다. 첫 번째 이미지에서는 프롬프트 창 상단의 드롭다운 메뉴를 통해 원하는 모델을 선택할 수 있으며, 채팅창에 PDF, 이미지, 코드 파일을 드래그 앤 드롭하여 모델에 입력할 수 있습니다. 두 번째 이미지와 같이 Gemma 3와 같이 비전 기능을 지원하는 모델을 선택하면 이미지 파일도 인식하여 처리할 수 있습니다.

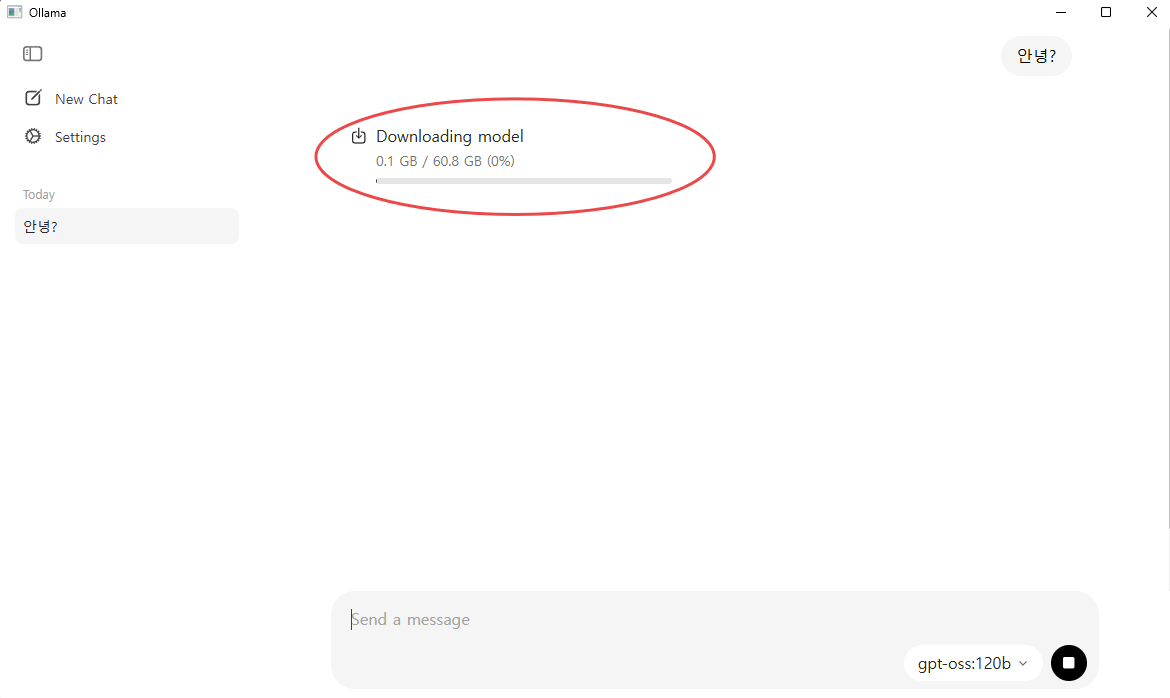

Ollama는 이러한 모든 작업을 로컬 환경에서 직접 실행합니다. 실행되는 모델은 대부분 양자화(Quantized) 된 형태이기 때문에, 일반적인 사양의 PC에서도 효율적으로 작동합니다. 다만, 사용하는 모델의 크기와 복잡도에 따라 GPU 및 메모리 성능에 따른 차이가 발생할 수 있습니다. 또한, 선택한 모델이 로컬에 없는 경우에는 자동으로 다운로드되어 실행됩니다. (아래 이미지 참고)

🛠️ 참고 사항

- 모델별 요구 사양 상이 : 실행하는 모델 크기에 따라 RAM, VRAM 요구 수준이 달라지며, 대형 모델일수록 고사양 환경에서 성능이 향상됩니다.

- 로컬 실행 기반 : 모든 연산이 사용자 PC에서 이루어지므로, 인터넷 연결 없이도 작동하며 데이터 유출 우려가 적습니다.

- 고급 기능은 CLI 필요 : 모델 푸시(push), 커스텀 모델 빌드(create) 등 일부 기능은 터미널(CLI)에서만 사용할 수 있습니다.

- 외부 연동 가능 : LangChain, Open WebUI, Llamafile 등과 연동하여 웹 검색, 장기 기억 등 확장 기능을 구현할 수 있습니다.

- 모델 자동 캐싱 : 선택한 모델은 로컬에 저장되며, 한 번 다운로드한 모델은 이후 오프라인에서도 재사용 가능합니다.

🧩 마무리

Ollama의 새 데스크톱 앱은 로컬 LLM 활용의 진입 장벽을 크게 낮추며, 개발자뿐만 아니라 일반 사용자도 손쉽게 AI 모델을 다룰 수 있는 환경을 제공합니다. GUI 기반의 직관적인 인터페이스, 파일 입력의 간편함, 오프라인 환경에서의 안전한 실행까지, 실용성과 보안성을 모두 갖춘 도구입니다.

복잡한 설치 없이 바로 시작할 수 있으니, 지금 Ollama를 설치하고 자신만의 오프라인 AI 워크플로를 구축해보시기 바랍니다.

[참고 링크]

👉 Ollama 공식 블로그 : https://ollama.com/blog/new-app

👉 Ollama 다운로드 : https://ollama.com/download