한국어 AI 모델 Konan-LLM-OND, 주요 특징 및 간단한 사용법 예시

한국어 특화 LLM Konan-LLM-OND: 성능, 특징, 간단 예제 코드 확인

Konan-LLM-OND는 코난테크놀로지가 공개한 한국어 중심 대규모 언어 모델입니다. Qwen3-4B-Base를 바탕으로 한국어 어휘 확장, 지속적 사전 학습, 지시어 튜닝 과정을 통해 효율성과 정확성을 동시에 강화합니다. 본 글에서는 모델의 핵심 특징을 정리하고, 로컬 환경에서 바로 활용 가능한 간단 예제 코드를 함께 소개합니다.

Konan-LLM-OND 란

konantech/Konan-LLM-OND는 코난테크놀로지가 공개한 대규모 언어 모델(LLM)입니다. Qwen3-4B-Base 모델을 기반으로 한국어 성능과 효율성을 극대화하기 위해 어휘 확장, 지속적인 사전 학습(Continual Pre-training), 그리고 지시어 튜닝(Instruction Tuning)을 거쳤습니다.

기본 정보

- 기반 모델(Base Model):

Qwen3-4B-Base - 주요 언어: 한국어 (영어 지원)

- 라이선스:

apache-2.0

주요 특징

- 확장된 한국어 어휘

- 한국어 토큰을 추가하여 모델의 어휘집을 확장했습니다.

- 이를 통해 기존 Qwen3 모델 대비 한국어 입력에 대한 토큰화 효율성이 약 30% 향상되었습니다.

- 결과적으로 더 빠른 처리 속도와 비용 효율성을 제공합니다.

- 지속적인 사전 학습 (Continual Pre-training)

- 확장된 어휘를 사용하여 대규모 한국어 말뭉치에 대한 사전 학습을 추가로 진행했습니다.

- 이 과정을 통해 모델의 기본적인 한국어 이해 및 텍스트 생성 능력을 강화했습니다.

- 지도 미세 조정 (Supervised Fine-Tuning, SFT)

- 고품질의 한국어 지시어(Instruction) 데이터셋으로 미세 조정을 수행했습니다.

- 이를 통해 실생활의 다양한 태스크를 이해하고 실행하는 능력을 향상시켰습니다.

벤치마크 성능

다양한 벤치마크 테스트에서 모델의 성능을 측정했으며, lm-evaluation-harness 프레임워크를 사용하여 평가를 진행했습니다.

Konan-LLM-OND 주요 벤치마크 성능

| 구분 | 벤치마크 | 점수 (Score) | 주요 특징 |

|---|---|---|---|

| 한국어 | KMMLU (지식) | 50.6 | 5B 이하 모델 중 1위 |

| HRM8k (수학 추론) | 46.4 | 7B 이상 모델 포함 전체 1위 | |

| Ko-IFEval (지시 이행) | 68.4 | 상위권 성능 | |

| 영어 | MMLU (지식) | 68.8 | 경쟁 모델 대비 우수 |

| GSM8K (수학 추론) | 86.8 | 5B 이하 모델 중 1위 |

■ KMMLU (5-shot): 한국어 객관식 문제를 통한 일반 지식 평가. 5개 예시 제공 후 답변 생성.

■ Ko-HRM8K (5-shot): 한국어 수학·논리 문제 기반 복합 추론 평가. 5개 하위 항목 평균 사용.

■ Ko-IFEval (0-shot): 한국어 지시문 이행 정확도 평가. 예시 없이 즉시 답변 생성.

■ MMLU (5-shot): 영어 객관식 문제를 통한 일반 지식 평가. 5개 예시 제공 후 답변 생성.

■ GSM8K (5-shot): 영어 초등 수학 문제 기반 단계적 추론 평가. 5개 예시 제공.

출처

- Konan-LLM-OND 허깅페이스 : https://huggingface.co/konantech/Konan-LLM-OND#model-performance-%EF%BC%9C-5b

간단한 실행 방법 (로컬 환경)

로컬 환경에서 Konan-LLM-OND 모델을 간단히 실행하는 방법에 대해 알아보겠습니다.

[테스트 실행 환경]

- 운영체제 : Windows 11

- python : 3.10.11

- torch : 2.6.0+cu126

- transformers : 4.53.3

- accelerate : 1.9.0

- GPU : NVIDIA GeForce RTX 4060 Ti

[모델 다운로드]

먼저, 아래 링크의 허깅페이스 저장소에 접속하여 모델 파일을 다운로드합니다. Files 탭에 있는 모든 파일을 내려받아 하나의 폴더 안에 저장합니다.

- 코난테크놀로지 허깅페이스 : https://huggingface.co/konantech/Konan-LLM-OND/tree/main

[코드 작성]

Konan-LLM-OND 모델을 실행하기 위한 간단한 파이썬 예제 코드를 아래와 같이 작성합니다.

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "Path/to/Konan-LLM-OND" # Konan-LLM-OND 모델 파일 경로 (사용자 환경에 맞게 수정)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto",

)

model.eval()

tokenizer = AutoTokenizer.from_pretrained(model_name)

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "대한민국 수도는?"} # 입력 프롬프트

]

input_ids = tokenizer.apply_chat_template(messages, add_generation_prompt=True, return_tensors="pt").to(model.device)

with torch.no_grad():

output = model.generate(

input_ids,

max_new_tokens=64,

do_sample=False,

)

len_input_prompt = len(input_ids[0])

response = tokenizer.decode(output[0][len_input_prompt:], skip_special_tokens=True)

print(response)

[실행 결과]

Konan-LLM-OND 모델의 로컬 실행 테스트를 통해 반응 속도, 언어 처리 능력, 번역 품질을 종합적으로 점검했습니다. 모든 테스트는 NVIDIA RTX 4060 Ti 환경에서 진행되었으며, 약 9.8GB의 VRAM을 일관되게 사용했습니다.

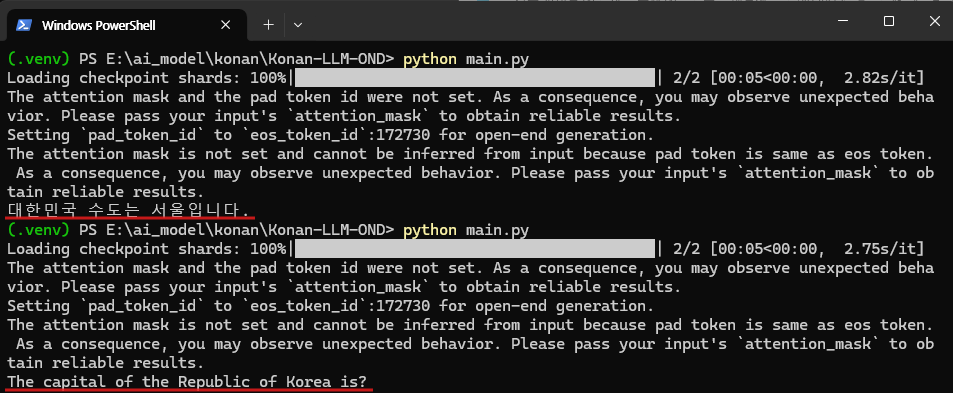

1. 간단한 질의 응답 테스트

- 프롬프트:

대한민국 수도는? - 결과:

"대한민국 수도는 서울입니다."(약 1초 소요) - 분석: 기본적인 한국어 질문에 대한 이해도와 응답 생성 능력이 매우 빠르고 정확함을 확인했습니다.

2. 한글 → 영어 번역 테스트 (단문)

- 프롬프트:

"대한민국 수도는?" - 결과:

"The capital of the Republic of Korea is?"(약 1초 소요) - 분석: 한국어 질문의 의도를 정확히 파악하고, 동일한 의미의 영어 의문문으로 올바르게 번역했습니다. 핵심 키워드("대한민국 수도")를 성공적으로 변환하고 문장 구조를 유지했습니다.

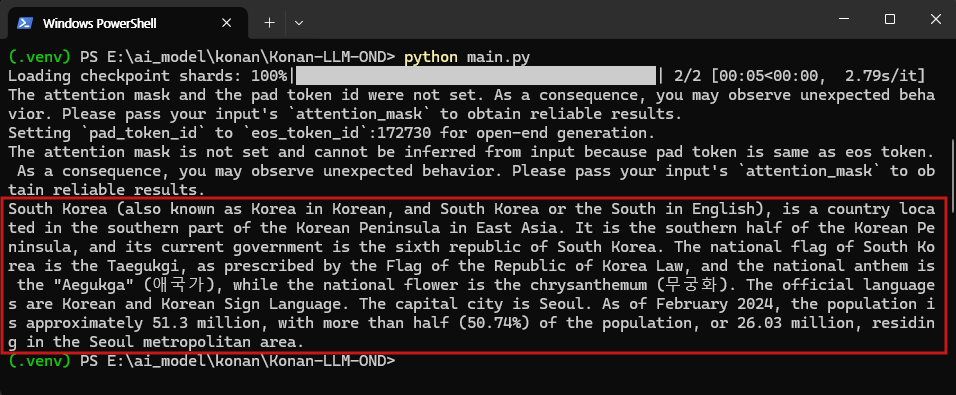

3. 한글 → 영어 번역 테스트 (장문)

- 입력: 대한민국에 대한 서술형 설명 전체 (아래 이미지 참조, 약 15초 소요)

- 결과: 전반적인 문맥과 흐름은 자연스러웠으나, 일부 어휘 선택에서 오역이 발견되어 정확도는 다소 낮았습니다.

- 분석: 긴 문장의 구조를 이해하고 영어로 변환하는 능력을 갖추고 있으나, 세부적인 번역 정확도는 개선이 필요해 보입니다.

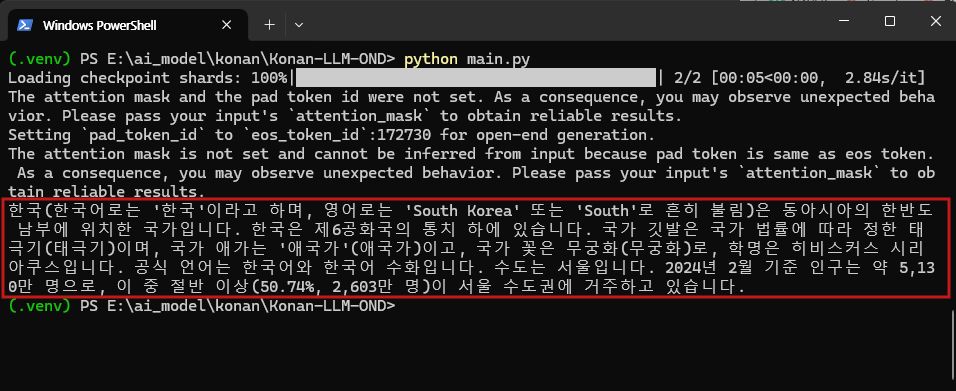

4. 영어 → 한글 번역 테스트 (장문)

- 입력: 한국에 대한 영문 설명 전체 (아래 이미지 참조, 약 15초 소요)

- 결과: 일부 표현이 다소 어색했지만, 원문의 의미를 정확하게 한국어 문장으로 번역했습니다.

- 분석: 영어 원문의 핵심 의미를 파악하고, 문맥에 맞는 한국어로 재구성하는 능력이 뛰어납니다.

위 테스트를 통해 Konan-LLM-OND 모델은 온디바이스용 경량 모델임에도 불구하고, 즉각적인 질의응답과 수준급의 영한 번역 능력을 갖춘 것을 확인할 수 있었습니다. 전문적인 한영 번역보다는 일상적인 문맥 파악 및 요약, 그리고 정확성이 중요한 영한 번역 작업에서 충분히 유용하게 활용될 것으로 기대됩니다.

마치며

지금까지 Konan-LLM-OND 모델의 주요 특징부터 간단한 사용법 예시, 그리고 실제 테스트 결과까지 자세히 살펴보았습니다. 한국어 환경에 최적화된 경량 모델임에도 불구하고, 기대 이상의 질의응답 성능과 특히 안정적인 영한 번역 능력을 보여주는 점이 매우 인상적이었습니다. 이는 온디바이스(On-device)와 같이 제한된 자원 환경에서도 충분히 실용적인 가치를 가질 수 있음을 의미합니다.

Konan-LLM-OND와 같은 모델의 등장은 국내 AI 기술 생태계가 착실히 성장하고 있다는 긍정적인 신호입니다. 앞으로 우리말을 더 잘 이해하고 우리에게 꼭 필요한 기능들을 갖춘 AI 모델들이 계속해서 발전하여, 우리의 일상과 업무를 더욱 풍요롭게 만들어 주기를 기대합니다.

감사합니다.

[참고 링크]

👉 코난테크놀러지 공식페이지 : https://www.konantech.com/

👉 코난테크놀러지 허깅페이스 : https://huggingface.co/konantech/Konan-LLM-OND