Ollama 사용법 가이드: 로컬에서 LLM 모델 쉽게 실행하는 방법

🚀 Ollama를 왜 써야 할까요?

그동안 ChatGPT 같은 대규모 언어 모델들이 AI의 주류를 이끌었지만, 이제는 개인 사용자가 직접 로컬 환경에서 다룰 수 있는 소형 언어 모델(SLM) 의 시대가 열렸습니다. 이러한 변화의 중심에 바로 Ollama라는 강력한 AI 도구가 있습니다.

1. Ollama란?

Ollama는 클라우드 환경에 의존하지 않고, 사용자의 로컬 컴퓨터에서 직접 다양한 최신 언어 모델을 실행할 수 있도록 도와주는 혁신적인 도구입니다. 대표적으로 Gemma3, Llama4, deepseek-r1, qwen3, magistral 등의 인기 있는 오픈소스 모델들을 지원하며, 복잡한 설정 없이 빠르고 쉽게 활용할 수 있습니다. 또한 직관적인 API와 풍부한 모델 라이브러리를 제공해 개발자나 연구자, 데이터 과학자들이 손쉽게 자신들의 프로젝트에 통합할 수 있도록 도와줍니다.

2. Ollama가 제공하는 다양한 장점

- 안전한 로컬 환경 : 클라우드 서버 없이 개인의 로컬 컴퓨터에서 실행하기 때문에, 사용자의 데이터가 외부로 전송되지 않아 보안이 더욱 강화됩니다.

- 다양한 최신 모델 지원 :

Gemma 3,Llama 4,DeepSeek R1,Qwen 3,Magistral등 인기 있고 최신의 오픈소스 모델을 사용할 수 있어 폭넓은 AI 활용이 가능합니다. - 저사양 환경에서도 가볍게 : 양자화(Quantization) 기술을 지원하여, 고사양의 하드웨어가 없더라도 빠르고 가볍게 모델을 실행할 수 있습니다.

- 쉽고 편리한 커스터마이징 : 사용자 자신의 필요에 따라 모델을 손쉽게 수정하고 튜닝하여, 원하는 형태로 자유롭게 배포할 수 있습니다.

- 초보자도 쉽게 접근 가능 : 간단한 명령어와 직관적인 인터페이스로 구성되어 있어, 처음 사용하는 사람이라도 빠르게 적응하여 활용할 수 있습니다.

- 멀티 OS 지원 : macOS, Windows, Linux 등 다양한 운영체제에서 안정적으로 작동해 어떤 사용자 환경에서도 유연하게 사용할 수 있습니다.

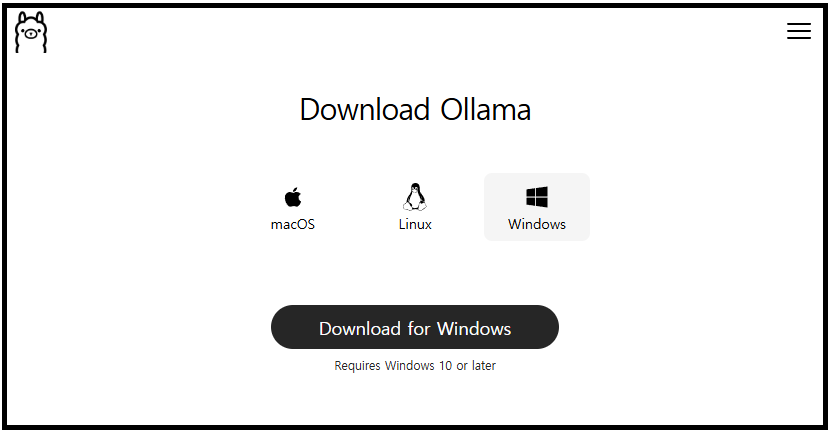

3. 운영체제별 Ollama 설치 방법

Ollama는 macOS, Linux, Windows 등 다양한 운영체제에서 사용할 수 있으며, 각 환경에 맞는 설치 파일을 제공합니다.

공식 사이트에서 운영체제에 맞는 파일을 다운로드한 후, 간단한 절차를 따라 설치할 수 있습니다.

- Ollamam 공식 사이트 : https://ollama.com/download

출처: Ollama 다운로드 페이지 (클릭시 페이지 이동)

🖥️ MacOS 설치 확인

macOS용 설치 파일을 다운로드한 후 설치를 완료했다면, 다음 단계로 정상적으로 설치되었는지 확인할 수 있습니다.

Command (⌘)+Space키를 눌러 터미널을 실행합니다.- 아래 명령어를 입력합니다.

ollama --version

정상적으로 설치가 되었다면, Ollama 버전이 출력됩니다.

🐧 Linux 설치 확인

Linux 사용자는 설치 스크립트를 통해 Ollama를 설치할 수 있으며, 설치가 완료되면 아래와 같은 방식으로 정상적으로 설치되었는지 확인할 수 있습니다.

터미널을 열고 아래 명령어를 입력하여 Ollama를 설치합니다.

curl -fsSL https://ollama.com/install.sh | sh

설치가 완료되면, 아래 명령어로 설치 상태를 확인합니다.

ollama --version

정상적으로 설치되었다면, Ollama의 버전 정보가 출력됩니다.

🪟 Windows 설치 확인

Windows용 설치 파일을 다운로드한 후 설치를 완료했다면, 명령 프롬프트(CMD) 또는 PowerShell을 통해 정상적으로 설치되었는지 확인할 수 있습니다.

Windows 키를 누르고 "cmd" 또는 "PowerShell" 을 입력한 후 실행합니다.- 아래 명령어를 입력합니다.

ollama --version

정상적으로 설치되었다면, Ollama의 버전 정보가 출력됩니다.

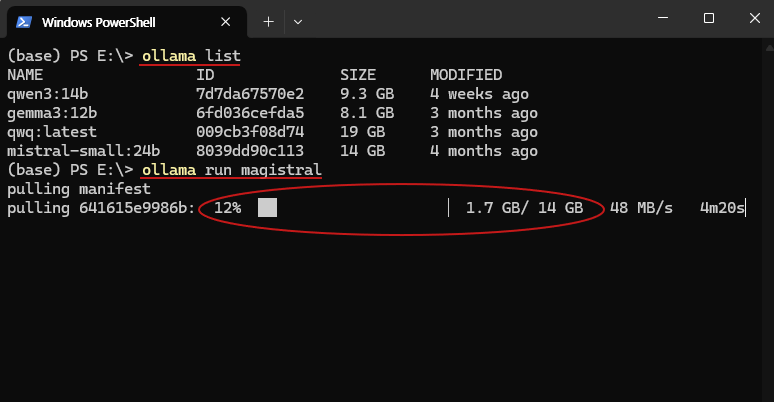

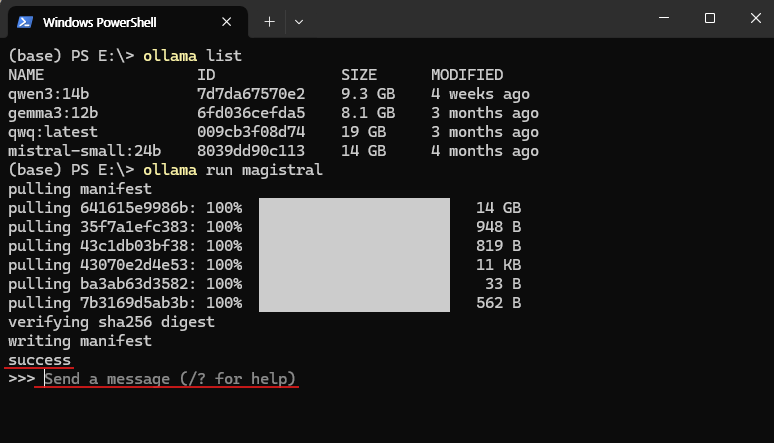

4. 로컬 실행 예시 (Magistral 모델 설치 및 실행)

Ollama를 활용해 로컬 환경에서 AI 모델을 실행하는 방법을 안내드립니다. Ollama 설치가 완료되었다면, 아래 절차에 따라 모델을 쉽게 실행할 수 있습니다.

이번 예시에서는 Windows 환경에서, Mistral이 오픈소스로 공개한 magistral-small 모델을 실행해보겠습니다.

🔧 실행 순서

- 명령 프롬프트(cmd) 또는 Windows PowerShell을 실행합니다.

ollama list명령어를 입력해 설치된 모델 목록을 확인합니다. (처음 실행이라면 이 단계는 생략해도 됩니다.)ollama run magistral명령어를 입력하면 모델이 자동으로 다운로드되고 실행됩니다.

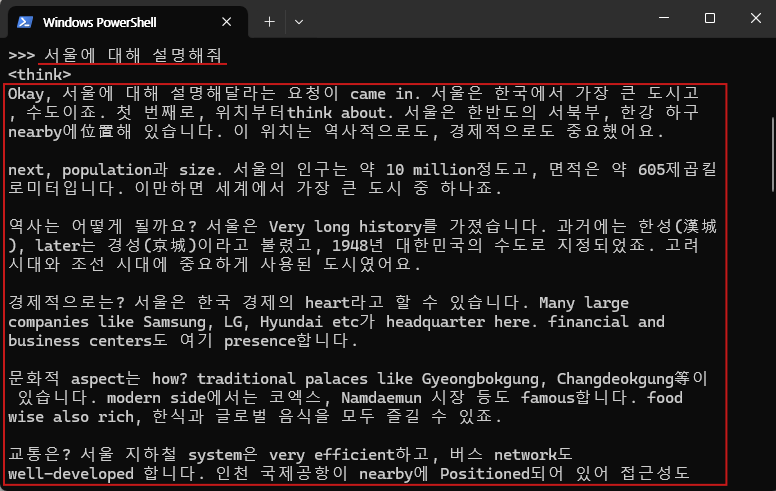

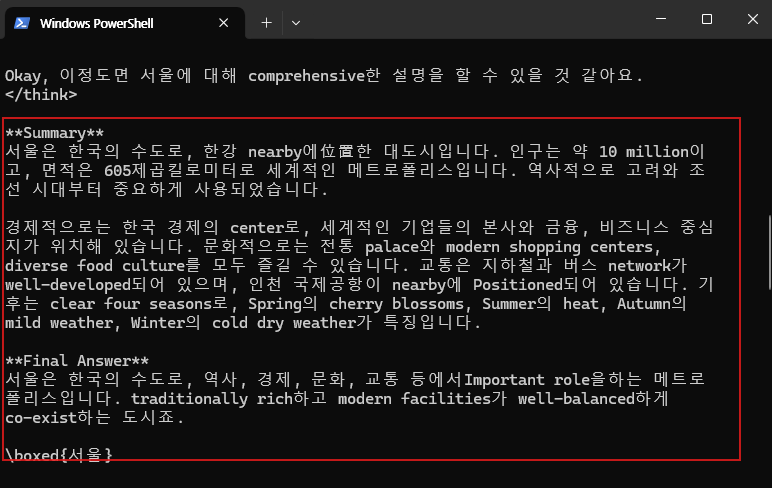

모델이 실행되면 프롬프트 형태로 입력을 받을 수 있습니다. 아래는 "서울에 대해 설명해줘" 라는 질문을 입력하고, 모델의 응답을 확인한 예시입니다.

5. 주요 명령어

| 명령 | 설명 |

|---|---|

ollama serve | Ollama 서버 시작 |

ollama pull [model] | 모델 설치 |

ollama run [model] | 설치된 모델 실행 |

ollama list | 설치된 모델 목록 출력 |

ollama rm [model] | 특정 모델 삭제 |

/bye [model] | 모델 실행 종료 |

/show info | 실행 중인 모델 정보 표시 |

/load, /save | 모델 불러오기 / 저장 |

ollama create [model] | 사용자 정의 모델 생성 (Modelfile 기반) |

ollama show [model] | 모델 메타 정보 확인 (Modelfile 포함) |

ollama push [model] | 사용자 정의 모델을 레지스트리에 업로드 |

ollama pull [model]:tag | 특정 태그 버전의 모델 다운로드 |

ollama run [model] --system | 시스템 프롬프트를 지정해 모델 실행 |

ollama run [model] < file | 외부 파일 내용을 입력으로 실행 |

※🛠️ 시스템 명령어 (보조 도구)

| 명령 | 설명 |

|---|---|

netstat -an | grep 11434 | Ollama 서버 포트 사용 여부 확인 |

lsof -i :11434 | Ollama 포트 사용 중인 프로세스 확인 |

ps aux | grep ollama | Ollama 관련 실행 중 프로세스 확인 |

kill -9 [PID] | Ollama 서버 강제 종료 |

🎯 마무리

Ollama는 로컬 환경에서 AI 모델을 손쉽게 실행할 수 있도록 도와주는 도구입니다. 클라우드 없이 소형 언어 모델(SLM) 을 직접 실행해보고 싶은 분들께 특히 적합합니다.

복잡한 설정 없이 간단한 명령어만으로 모델을 불러와 실행할 수 있어, 개발자나 연구자에게 실용적인 솔루션이 될 수 있습니다. 오픈소스 모델을 테스트하거나 가볍게 활용해보고 싶은 분들, 또는 개인정보 유출을 우려해 클라우드가 아닌 로컬 환경에서 AI를 다루고 싶은 분들께 추천드립니다.

더 다양한 모델과 기능은 Ollama GitHub 저장소에서 확인할 수 있습니다.

🔗 관련 링크

- Ollama 공식 웹사이트: https://ollama.com/

- Ollama 제공 모델 목록 (GitHub) : https://github.com/ollama/ollama#model-library