AI가 직접 컴퓨터를 조작한다? 오픈소스 프로젝트 OpenCUA 소개

컴퓨터를 직접 조작하는 AI 에이전트 오픈소스 프레임워크

최근 인공지능 분야에서는 단순히 언어를 이해하는 수준을 넘어, 실제 컴퓨터 환경을 스스로 다루는 AI 에이전트 연구가 활발히 진행되고 있습니다. 웹 브라우저 탐색, 소프트웨어 실행, 파일 관리와 같은 일상적인 작업을 사람이 아닌 AI가 직접 수행하도록 만드는 것이 목표이며, 이를 위해 다양한 접근 방식이 제안되고 있습니다.

OpenCUA는 이러한 흐름 속에서 공개된 대표적인 오픈 소스 프로젝트로, 연구자와 개발자가 누구나 실험하고 검증할 수 있도록 설계되었습니다. 다만 현재는 제한된 시뮬레이션 환경(OSWorld)을 기반으로 실험 단계에 있으며, 범용적으로 활용 가능한 완성형 AI 에이전트라기보다는 테스트와 연구를 위한 기반 플랫폼에 가깝습니다.

📌 OpenCUA 란

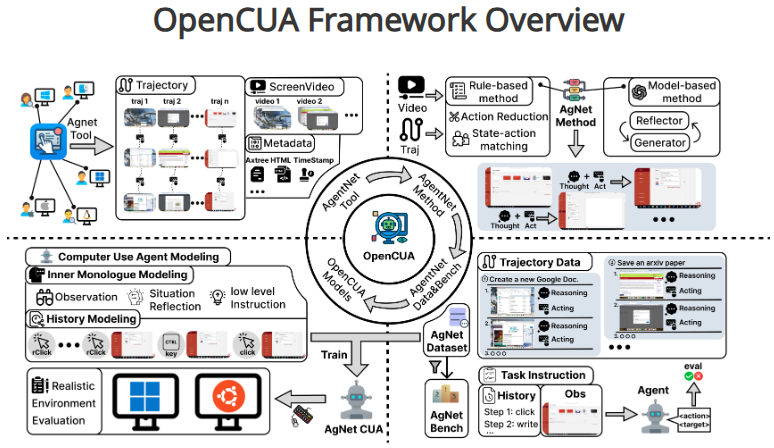

OpenCUA는 컴퓨터 사용 에이전트(Computer-Use Agents, CUA) 연구를 위해 제안된 포괄적인 오픈 소스 프레임워크입니다. 이 프레임워크는 비전-언어 모델(Vision-Language Models, VLM) 을 기반으로 하여, 컴퓨터 화면을 인식하고 추론한 뒤 실제 사용자처럼 마우스·키보드 입력을 통해 작업을 수행하는 것을 목표로 합니다. 특히 기존 CUA 시스템이 지니던 불투명성 문제를 해결하고, 학계와 산업계 모두에서 활용 가능한 투명한 연구 기반을 마련하는 데에 중점을 두고 있습니다.

- OpenCUA 프로젝트 페이지 : https://opencua.xlang.ai/

출처: OpenCUA 프로젝트 페이지

🧩 주요 구성 요소

OpenCUA는 CUA 생태계를 전반적으로 구축하기 위해 다음 네 가지 핵심 구성 요소를 제공합니다.

- AgentNet : Windows, macOS, Ubuntu를 포함한 다양한 운영체제와 200개 이상의 애플리케이션 및 웹사이트에서 수집된 22.6K 작업 데이터셋으로, 대규모 컴퓨터 사용 작업을 포괄합니다.

- AgentNetTool : 사람의 컴퓨터 사용 과정을 끊김 없이 캡처하는 주석 인프라 도구입니다. 화면 비디오, 마우스 및 키보드 이벤트, 접근성 트리(Axtree)까지 기록하여 학습용 데이터를 만듭니다.

- AgentNetBench : 모델이 생성한 저수준 액션과 실제 궤적을 비교할 수 있는 오프라인 평가 도구입니다. OSWorld와 같은 온라인 벤치마크의 높은 비용 문제를 보완합니다.

- OpenCUA 모델 : 종단간(end-to-end) 구조로 설계된 컴퓨터 사용 파운데이션 모델로, 스크린샷 기반 인식과 추론을 거쳐 실행 가능한 PyAutoGUI 스타일 액션을 생성합니다.

⚙️ 작동 방식 및 방법론

OpenCUA 에이전트는 크게 관찰 → 추론 → 액션 실행의 주기를 따릅니다. 이는 사람이 모니터 화면을 보고 상황을 이해한 뒤 머릿속으로 판단을 내리고, 손으로 마우스와 키보드를 움직여 컴퓨터를 조작하는 과정과 매우 유사한 방식으로 설계되어 있습니다.

- 관찰 : 컴퓨터 화면의 스크린샷을 입력으로 받아 현재 상태를 인식합니다. (사람이 모니터를 바라보며, 어떤 창이 열려 있고 버튼이 어디에 있는지를 눈으로 확인하는 것과 같이 작동)

- 추론 : ‘내면의 독백(inner monologue)’ 형식으로 계획, 기억, 반성을 포함한 Chain-of-Thought(CoT) 추론을 수행합니다. (사람이 화면을 본 뒤, 머릿속으로 “다음에는 이 버튼을 눌러야겠다”라거나 “조금 전에 잘못 클릭했으니 다시 돌아가야겠다”라고 생각하는 것처럼 추론)

- L3: 상황적 관찰

- L2: 반성적 사고와 계획

- L1: 실제 실행 가능한 액션

- 액션 실행 : click(x, y), write(text), press(key)와 같은 PyAutoGUI 스타일의 저수준 명령을 출력하고 실행합니다. (사람이 실제로 마우스를 움직여 버튼을 누르거나 키보드로 글자를 입력하는 것과 같이 작동)

또한, OpenCUA는 액션 축소(Action Reduction), 상태-액션 매칭(State-Action Matching), 여러 스크린샷 기반 컨텍스트 인코딩, 다양한 CoT 레벨 데이터 혼합을 통해 실제 환경과 유사한 학습을 가능하게 합니다.

📊 성능 평가

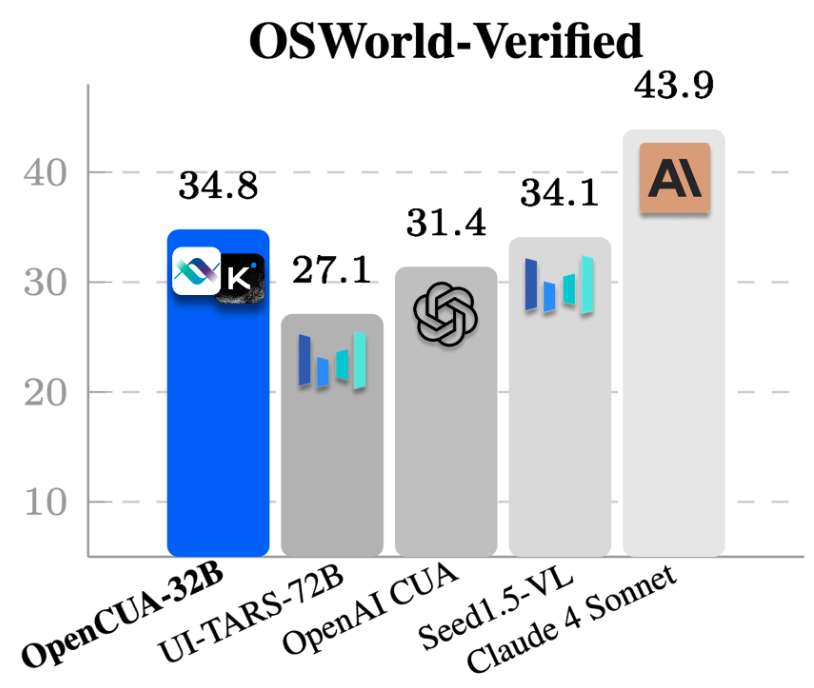

이 프로젝트에서 공개한 OSWorld-Verified 에이전트 평가 결과에 따르면, OpenCUA-32B 모델은 평균 성공률 34.8% 를 기록하며 오픈소스 계열 모델 중 가장 높은 성능을 보였습니다. 이는 OpenAI CUA(31.4%), UI-TARS-72B(27.1%), Seed1.5-VL Claude 4 Sonnet(34.1%) 을 앞서는 결과로, 제한된 연구 환경(OSWorld)임에도 불구하고 경쟁력 있는 성능을 입증했습니다.

다만, 상용 모델인 Anthropic Claude 계열(43.9%)에는 아직 차이가 존재하며, 이는 OpenCUA가 연구·실험 단계의 오픈소스 프레임워크라는 점을 잘 보여줍니다.

- OpenCUA 프로젝트 페이지 : https://opencua.xlang.ai/

출처: OpenCUA 프로젝트 페이지

📜 라이선스

OpenCUA 프로젝트는 MIT 라이선스를 따르고 있으며, 여기에는 프레임워크 코드뿐 아니라 모델 학습에 활용된 비전-언어 모델(VLM) 역시 동일하게 적용됩니다. MIT 라이선스는 가장 자유도가 높은 오픈소스 라이선스 중 하나로, 다음과 같은 특징을 가집니다.

- 상업적 사용 허용 : 기업 및 개인은 OpenCUA 코드를 활용하여 자체 서비스나 제품을 개발·판매할 수 있습니다.

- 수정 및 재배포 가능 : 연구 목적뿐 아니라 맞춤형 수정 및 파생 프로젝트 개발도 자유롭게 진행할 수 있습니다.

- 책임 한정 : 코드 및 모델 사용으로 발생하는 문제에 대해 원 저작자는 법적 책임을 지지 않습니다.

즉, OpenCUA는 단순히 연구용으로만 제한되는 프로젝트가 아니라, 상업적 활용까지 열려 있는 오픈소스 AI 에이전트 프레임워크라고 할 수 있습니다. 다만, 실제 배포나 서비스 단계에서는 데이터셋 저작권, 개인정보 보호, 보안 이슈 등 추가적인 법적·윤리적 검토가 필요합니다.

[관련 링크]

- OpenCUA 깃허브 : https://github.com/xlang-ai/OpenCUA

- OpenCUA 허깅페이스 : https://huggingface.co/xlangai/OpenCUA-7B

🛠️ 현재 개발 단계와 한계

개발 진행 상황

- 2025년 8월, 논문과 함께 모델·코드·데이터셋이 모두 오픈소스로 공개되었습니다.

- AgentNetTool v1.0.0이 정식 릴리스되어, 연구자들은 직접 데이터 수집 및 실험을 진행할 수 있습니다.

- OSWorld-Verified 벤치마크에서 평균 성공률 34.8% 를 기록하며, 오픈소스 모델 중 최고 성능(SOTA) 을 달성했습니다.

현재 단계의 한계

- 제한된 환경(OSWorld) 내에서만 실험 가능 : 현재 코드는 실제 사용자 PC에서 모든 앱을 자유롭게 제어하는 범용 AI가 아니라, OSWorld 시뮬레이터 기반의 제한된 시나리오 수행을 목적으로 합니다.

- 범용 AI 에이전트 단계는 아님 : 텍스트 명령만 입력하면 모든 작업을 완벽히 수행하는 단계에 도달하지는 못했습니다. 연구 목적의 프로토타입 및 인프라 제공 단계라고 보는 것이 적절합니다.

✅ 마무리

OpenCUA는 단순한 모델 공개를 넘어, 데이터셋·주석 도구·평가 벤치마크·모델 코드까지 포함하는 포괄적 오픈소스 프레임워크입니다. 이를 통해 연구자와 개발자는 컴퓨터 사용 에이전트의 성능과 한계를 체계적으로 탐구할 수 있으며, 향후 더욱 강력한 범용 AI 에이전트로 발전할 수 있는 토대를 제공합니다.

다만 현재는 제한된 환경(OSWorld) 에 국한되어 있으며, 범용 텍스트 기반 AI 비서 수준에는 이르지 못했습니다. 따라서 OpenCUA는 현시점에서 “완성된 AI 에이전트”라기보다는, 향후 연구와 발전을 위한 기초 단계의 플랫폼으로 이해하는 것이 타당합니다.

감사합니다.

[참고 링크]

🔗 OpenCUA 프로젝트 페이지 : https://opencua.xlang.ai/

🔗 OpenCUA 깃허브 : https://github.com/xlang-ai/OpenCUA

🔗 OpenCUA 허깅페이스 : https://huggingface.co/xlangai/OpenCUA-7B